Comment gérer l'Open-Data

Avec le décret n° 2017-638 du 27 avril 2017 de la république numérique ouvrant l'accès aux données publiques, les fournisseurs d'informations sur les entreprises, de nouveaux acteurs digitaux et les grandes entreprises se sont mises à récolter et intégrer la plupart de ces jeux de données disponibles pour identifier et prospecter de manière plus efficace certains profils d'entreprises.

Cette profusion de sources de données apporte une vrai richesse mais nécessite de bien comprendre la source de ces données et comment bien cumuler toutes ces sources de manière efficace, sans que cela devienne un vrai sac de noeuds.

Comme le dit Christian Quest de l'Etalab, "la valeur de la donnée ne se révèle que lorsqu'on les relie entre elles". L'enjeu est là: relier les jeux de données de façon cohérente afin d'en tirer le meilleur parti.

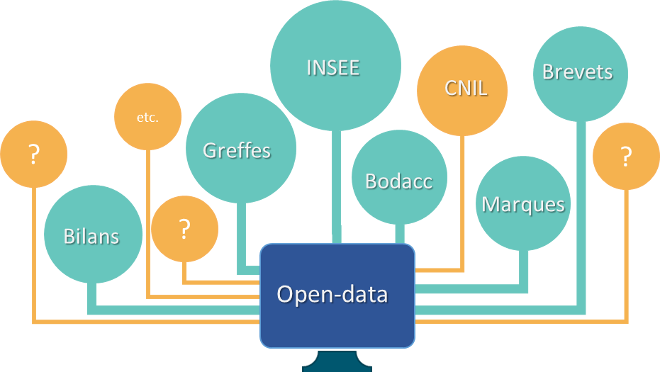

Open-data: une multitude de sources

L'open-data est un formidable atout et outil pour faire une photographie d'un marché, d'un acteur face à son environnement. Même sans connaître l'écosystème, on a de suite une première impression et des pistes qui éveillent l'intellect. Face à tant de données, trois interrogations essentielles doivent se poser:

- Les pistes et signes (manifestes) que l'on constate ont-ils un réel potentiel?

- Comment vont vivre ces signes dans le temps?

- Comment les relativiser avec d'autres sources?

Une expertise plus fine est nécessaire pour mieux appréhender les subtilités des données captées, ainsi que l'évolution de celles-ci.

La photo est donc facile à faire mais la réalisation d'un film devient une gageure, à savoir faire évoluer ces photographies dans le temps, et de les comparer avec d'autres sources gratuites disponibles: c'est un peu faire un montage vidéo avec une panoplie de caméra radicalement différentes.

Même avec mon expérience de plus de 15 ans dans le domaine, il m'arrive parfois de faire fausse route et de voir de nouvelles tendances qui en fait n'en sont pas. Prenez par exemple nombre de création d'entreprises au mois par mois par rapport à l'année précédente, vous constaterez qu'il est en chute libre, tout simplement parce que les entreprises tardent de plus en plus à se déclarer!

La toile de Pénélope ou la gestion multi-sources de l'open-data

Dès que l'on rattache plusieurs sources open-data, on constate des incohérences d'informations.

D'une part, il faut éviter de croire que l'open-data vertical offre une garantie de couverture et de frâicheur de données. Non, cela apporte une couverture officielle, une homogénéité dans la collecte (quoique...) et une certaine justesse dans le temps, si les tiers "collectés" ont fait leur travail: toutes les entreprises n'indiquent pas leur changement d'adresse, encore moins de métiers, de dirigeant et de publication bilantielle. Certains organismes de l'état sont d'ailleurs non identifiées (comme la DGES, sécurité oblige) mais vous seriez surpris par le nombre d'établissements ayant pignons sur rue sans leur fameux siret.

D'autre part, il faut bien prendre en compte la collecte de l'information initiale. La plupart des sources open-data de la république numérique, se base en effet sur la base SIRENE de l'INSEE, mais le plus souvent sur une vue annuelle, et donc pas vraiment à jour.

.

Dans une gestion multi-source de référentiel, il est impératif d'appréhender les effets asynchrones et contradictoires d'informations analogues (INSEE vs Bodacc vs Greffe). Ce télescopage d'informations va s'accroitre avec les jeux de données locales issues des métropoles et grandes villes qui sont désormais soumises à publication depuis octobre 2018. Et le fait que la donnée soit locale ne signifie pas qu'elle soit plus fraîche ou de meilleur qualité. Ces sources locales se basent souvent sur un "extract annuel" de l'INSEE, sur lequel ils ajoutent leurs données. Il faut donc bien distinguer quelle est la donnée de souche, et celle de référence, si on ne veut pas effacer une information plus fraîche et rendre ainsi caduque tout votre travail de constitution de data-lake.

Au final, c'est en identifiant dans chaque source open-data quelles sont les vraies données enrichies ou spécifiques, que vous pourrez tirer le meilleur et vous évitez ainsi de défaire la toile de pénélope en écrasant une donnée à jour par une donnée plus ancienne.

Par ailleurs, dans le domaine de l'information sur les entreprises, ces sources open-data ne sont pas toutes raccrochables au simple siren ou siret (l'identifiant unique de l'entreprise et de son établissement), il va vous falloir effectuer du rapprochement sémantique et géographique. Sachez que c'est le métier historique d'Altares et que mes collègues seront ravis de vous aider à maintenir et à fiabiliser ces bases.

Une fois tous les enregistrements recadrés, sirétisés, vous pouvez construire votre architecture d'informations.

Construire son référentiel d'open-data

Une fois que toutes vos données open-data recadrées, sirétisées, cadencées et filtrées vous avez 4 options:

- Façon Old-school: à savoir rajouter les valeurs qui vous interesse dans votre base de données (ou votre data-lake) en gérant convenablement les mises à jour. Mais bon, vous n'aurez pas fini de rajouter des champs à votre base de données, et de découvrir assez tard quelques effets de la toile de pénélope, où des données plus fraîches ont été écrasées par de plus anciennes.

- Façon relationnelle: rajouter autant de nouvelles tables que de sources et raccrocher chaque source via le siren ou siret, bref faire du SQL comme si cela était une simple base relationnelle

- ou bien faire la même chose en avec un data-hub et les techno NOSQL, de datalake, etc. mais bon, cela revient à la même chose: lire une table ou du texte avec une clé de rapprochement...

- Façon méta-sémantique: gérer une table pivot intelligente qui va agréger les informations issues des sources open-data.

C'est cette dernière option que je vous propose de travailler, surtout qu'elle vous évite les quelques complications légales sur la redistribution.

Une base sémantique pivot unique pour gérer tout l'open-data

Dans la construction de votre référentiel, l'enjeu est d'avoir une vision à 360° sur tout ce qu'apporte vos données et l'open-data sur une entreprise, mais surtout, de pouvoir requêter rapidement sur des critères simples, sans devoir créer de nouveaux index à chaque entrée de sources.

Dans la gestion des différentes sources, vous avez 2 éléments communs, 2 méta-informations: vous avez d'une part les informations qui caractérisent votre source open-data et d'autre part les informations qui y sont contenus. Je vous propose donc de gérer ces 2 tables

Informations générales sur la source (meta-base)

Et en méta-donnée, à savoir la source, vous avez besoin de répertorier ces informations:

- Dénomination

- Description courte / longue

- URL de la source et connexion via API (s'il y a)

- Périodicité de mise à jour de la base (quand est-ce cette base est mise à jour)

- Périodicité de mise à jour des éléments (une base bilan est par exemple annuelle; base auto: déclaration; base bodacc; base SNA: immuable)

- L'élément clé (ou clé de rapprochement) (le siren; siret; n° BAN; etc.)

- Liste des champs à récupérer

Informations générales sur le contenu (méta-sémantique)

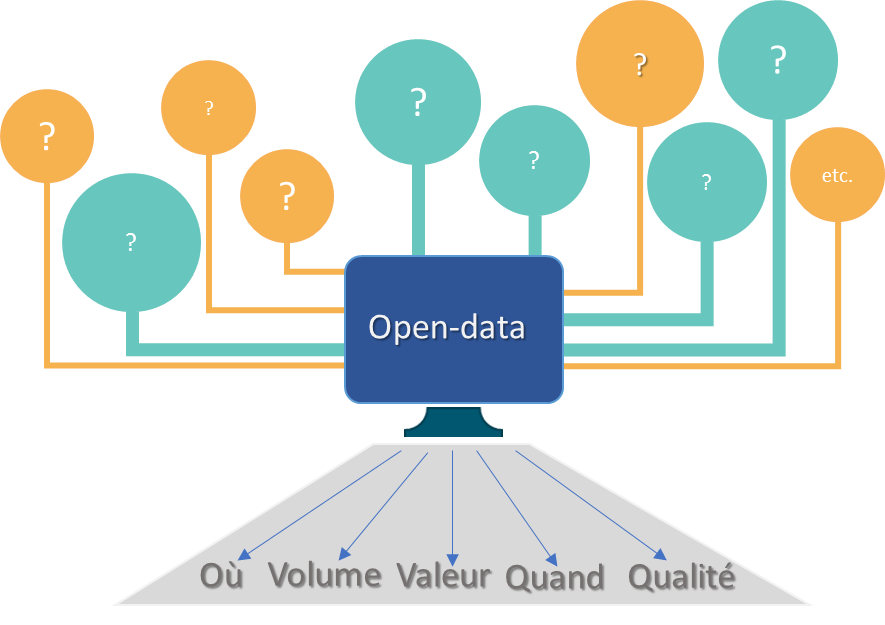

Quelque soit la source (liée à une entité économique) qu'est-ce qui est commun à tout élément de toutes ces sources? Et bien, tout simplement en se basant sur le fameux CQQCOQP (Comment; Quoi; Qui; Combien; Où; Quand; Pourquoi) et en se concentrant sur un statut factuel de l'élément étudié.

- Situation: une notion de localisation (géographique)

- Volume: une notion de quantité représentatif

- Valeur: une notion de valeur que représente l'élément (un billet de 100€ vs 100 pièces d'1€)

- Constance: les informations temporelle s liées à l'élément

- Date clés: création / fermeture

- Durée (ou fréquence): durée de vie

- Qualité: 3 informations possibles

- Etat: l'élément enregistré est-il actif / fermé; en cours / passé / à venir

- Appréciation:

- Caractéristiques: une notion purement intrinsèque à l'élément, reprise du verbatim ou qualificatif de la donnée, difficile à rendre de manière générique

- Etat: en cours de création; actif; en pause temporaire; en cours de fermeture; fermé

Vous disposez ainsi d'une grille de lecture multi-sources simple, concise et modulable pour toute nouvelle source.

Vous savez de suite: j'ai bien une information supplémentaire dans l'open-data, son importance en volume, en qualité et en récurrence, et sur laquelle vous devez relier à d'autres données pertinentes. C'est ainsi que vous accélerez la synergie de valeur de la Data, et c'est par ce Hub de données que vous créez la valeur.

Vous disposez ainsi d'une grille de lecture multi-sources simple, concise et modulable pour toute nouvelle source.

Vous savez de suite: j'ai bien une information supplémentaire dans l'open-data, son importance en volume, en qualité et en récurrence, et sur laquelle vous devez relier à d'autres données pertinentes. C'est ainsi que vous accélerez la synergie de valeur de la Data, et c'est par ce Hub de données que vous créez la valeur.

Il faudra toujours garder la source initiale, car c'est une donnée qui restera explicative ou nécessaire à une analyse plus approfondie d'une population d'éléments identifiés par votre Data-Hub. Enfin, la source initiale parfois nécessite d'être restitué dans un modèle propre: les données d'un bilan doivent se lire dans une matrice financière et non en ligne ou un simple tableau.

|